อีกหนึ่งปัญหาที่เกิดขึ้นบนโลกออนไลน์คือ Deepfake ที่สามารถใช้ AI มาปลอมแปลงเป็นบุคคลใดก็ได้ แถมยังจับคำพูดใส่ปากได้เหมือนตัวจริงจนแยกไม่ออก ทำให้เกิดปัญหากระจายข่าวปลอมและสร้างความเกลียดชังตามมา

ปัญหา Deepfake ถือว่าเป็นเรื่องที่ท้าทายของสื่อออนไลน์ เพียงแค่มีคอมพิวเตอร์และ GPU ทั่วไป เมื่อนำมาใช้งานกับซอฟท์แวร์ที่โหลดมาจากอินเทอร์เน็ตก็สามารถสร้างคลิปปลอมขึ้นมาได้แล้ว

หลายๆแพลตฟอร์มเริ่มพัฒนาระบบที่ช่วยตรวจจับคลิปปลอมที่สร้างขึ้นด้วยเทคโนโลยี Deepfake ก่อนที่จะเผยแพร่สู่ผู้คนในวงกว้าง ทางฝั่ง Twitter ได้เผยนโยบายใหม่ ‘Manipulated Media’ ในการจัดการรูปภาพและคลิปที่อาจจะสร้างปัญหา ด้วยการเพิ่มข้อความว่า มีองค์ประกอบที่สังเคราะห์ขึ้นมา เพื่อให้ผู้ใช้ได้พิจารณาข้อมูลอย่างถี่ถ้วน

ในขณะที่ Facebook นั้นพยายามหาหลายๆวิธีมาสร้างเป็นโมเดลการตรวจจับ Deepfake ของตัวเอง หนึ่งในนั้นคือการจัดการแข่งขันให้เหล่านักศึกษาพัฒนาเครื่องมือมาช่วยด้วย ซึ่งสัปดาห์นี้ผลการแข่งขันก็ประกาศออกมาเป็นที่เรียบร้อยแล้วซึ่งการแข่งขันครั้งนี้มีผู้เข้าร่วมมากกว่า 2,000 คนจากทั่วโลก

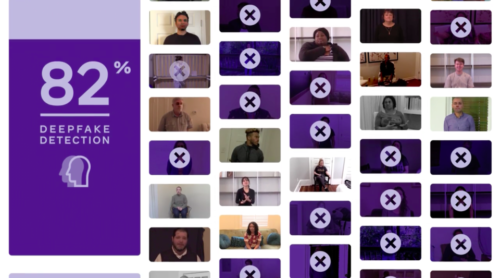

โมเดลที่สามารถตรวจสอบคลิปปลอมได้ดีที่สุดนั้น มีอัตราความแม่นยำอยู่ที่ 82% ซึ่งถือว่าทำได้อย่างน่าประทับใจ แต่ผลลัพธ์นั้นขึ้นกับการฝึกสอนนั่นหมายความว่า ถ้าฝึกมากๆก็จะเก่งขึ้นได้ ในการวัดความแม่นยำของระบบนี้ ทาง Facebook พิจารณาจากการใช้ข้อมูล Deapfake สาธารณะที่ทุกคนรู้อยู่แล้ว ร่วมกับ ‘black box’ ที่ประกอบด้วยคลิปวิดีโอ 10,000 คลิปซึ่งทางผู้เข้าแข่งขันไม่เคยเห็นมาก่อน รวมถึงไม่สามารถเข้าถึงได้ก่อนการแข่งขัน ซึ่งคลิปเหล่านี้จะถูกทำการเปลี่ยนแปลงเฟรมเรต, ความละเอียด, การซ้อนภาพเพื่อดูการวัดผล

เมื่อมองในภาพรวมของข้อมูลสาธารณะ ผลเฉลี่ยความแม่นยำของผู้เข้าแข่งขันทั้งหมดจะอยู่ที่ 82% ส่วนโมเดลที่มีประสิทธิภาพในการตรวจจับที่ดีที่สุดใน black box พัฒนาโดย Selim Seferbekov. มีความแม่นยำที่ 65.18%

ในทางทฤษฎีแล้วทาง Facebook เองสามารถพัฒนาโมเดลเหล่านี้ให้มีประสิทธิภาพสูงขึ้นได้ รวมถึงนำมาวางระบบตรวจสอบก่อนที่จะเผยแพร่ในวงกว้างได้

ที่มา socialmediatoday