ยุคนี้เป็นยุคของ ’จอ’ อะไรก็ทำผ่านจอเกือบหมด ไม่ว่าจะเป็นวัยไหน ก็ใช้จอกันเป็น แต่! หนึ่งเรื่องที่น่ากังวลคือการใช้จอของเด็ก ล่าสุดแอปเปิ้ลเตรียมปล่อยฟีเจอร์คุ้มครองเด็ก ช่วยตรวจสอบ สแกน เซ็นเซอร์ภาพที่ไม่เหมาะสม พร้อมรายงานผู้ปกครอง

ในปัจจุบันมีโลกออนไลน์เรา มีคอนเทนท์มากมายที่เข้าถึงได้ง่าย ซึ่งก็ต้องยอมรับว่า มันก็มีบางเนื้อหาที่อาจจะไม่เหมาะสมสำหรับเด็ก นอกจากเนื้อหาแล้วก็ยังมีเรื่องของโฆษณาอีกด้วย ล่าสุดApple เตรียมเพิ่มฟีเจอร์คุ้มครองความปลอดภัยให้กับเด็กที่มีอายุต่ำกว่า18 ปี ในการเข้าถึงวัตถุหรือสิ่งที่แสดงการล่วงละเมิดทางเพศเด็ก (Child Sexual Abuse Material : CSAM) ซึ่งฟีเจอร์นี้จะมาใน 3รูปแบบด้วยกัน

- ในแอปสำหรับการสื่อสาร

- ในการเข้าถึงข้อมูลแบบSIRI

- ในการค้นหาข้อมูลทั่วไป

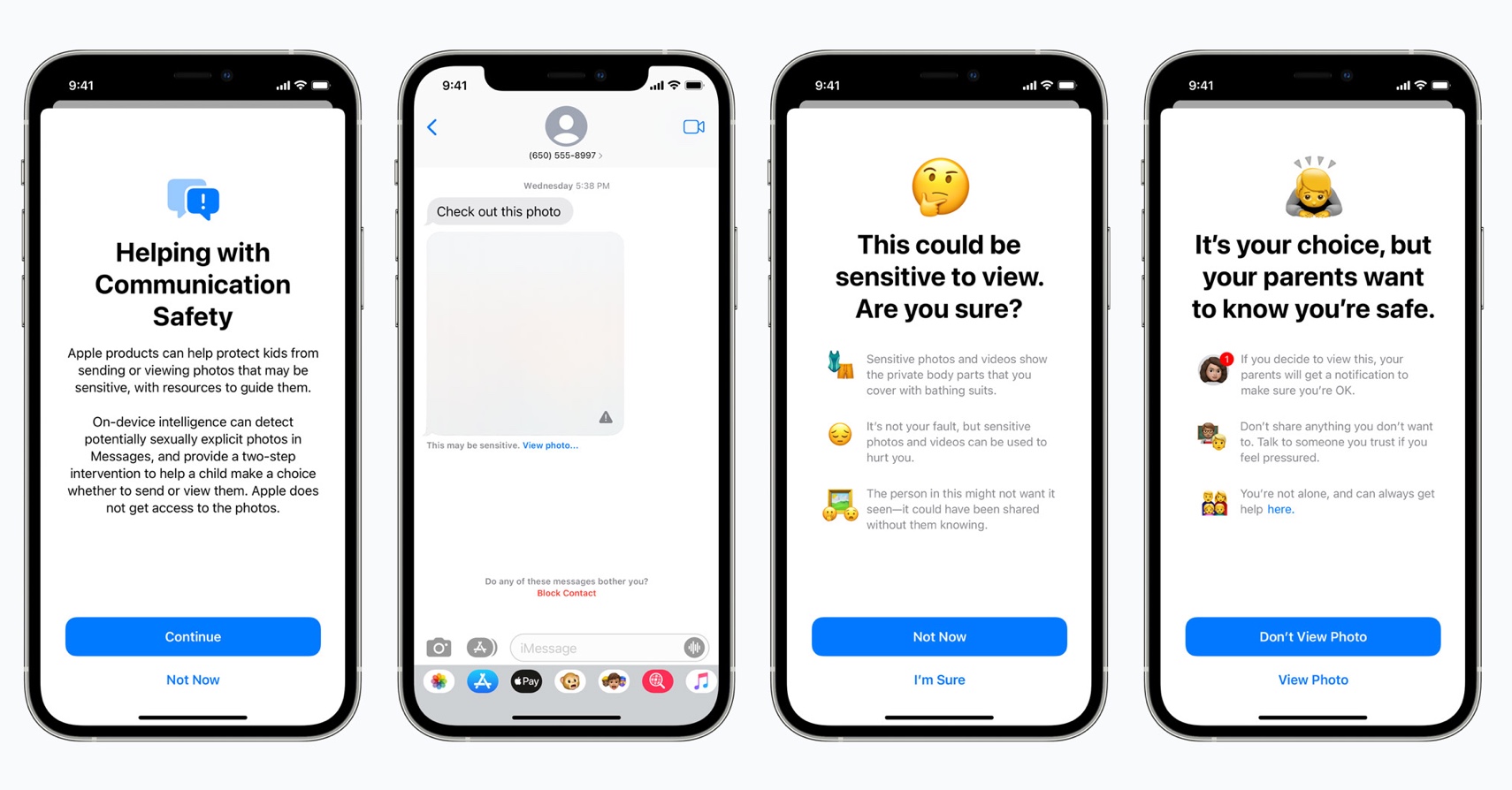

แอปการสื่อสารอย่างแอป ‘ข้อความ’(Messages) จะมีการเพิ่มเครื่องมือที่จะคอยเตือน เซ็นเซอร์ รวมถึงเบลอรูปภาพ ถ้ามีคนส่งรูปภาพอนาจารให้เด็กที่มีอายุต่ำกว่า18 ปี รวมถึงถ้าเด็กเป็นคนส่งรูปเอง รวมถึงจะแจ้งให้ผู้ปกครองรู้ทันที

ในส่วนของการค้นหาข้อมูลผ่าน SIRI และ SEARCH จะมีการเพิ่มฟีเจอร์แนะนำถึงความไม่ถูกต้องของCSAMด้วย โดยจะแจ้งเตือนผู้ใช้งานที่ต้องการหาข้อมูลเหล่านั้น ว่าเป็นเรื่องที่ไม่ถูกต้องพร้อมกับแนะนำวิธีแก้ปัญหา

ถามว่าทำงานยังไง?

แอปข้อความจะใช้ Machine Learning ในตัวเครื่องเพื่อวิเคราะห์และประมวลผลว่าภาพดังกล่าวเป็นภาพลามกอนาจารหรือเปล่า ถ้าตรวจเจอ ภาพก็จะถูกเบลอไว้ก่อน รวมถึงจะมีการแจ้งเตือนเด้งขึ้นมาถามว่าต้องการดูภาพนี้จริง ๆ หรือไม่ หากยืนยันว่าจะดู ระบบก็จะมีการแจ้งเตือนไปยังอุปกรณ์ของผู้ปกครอง ว่าลูกของท่านกำลังจะดูภาพที่ไม่เหมาะสมอยู่ค่ะ แต่ก่อนจะใช้ฟีเจอร์ได้ คุณจะต้องตั้งค่า Family ก่อนบนบัญชี Apple หรือ iCloud

แล้วแม่นยำไหม?

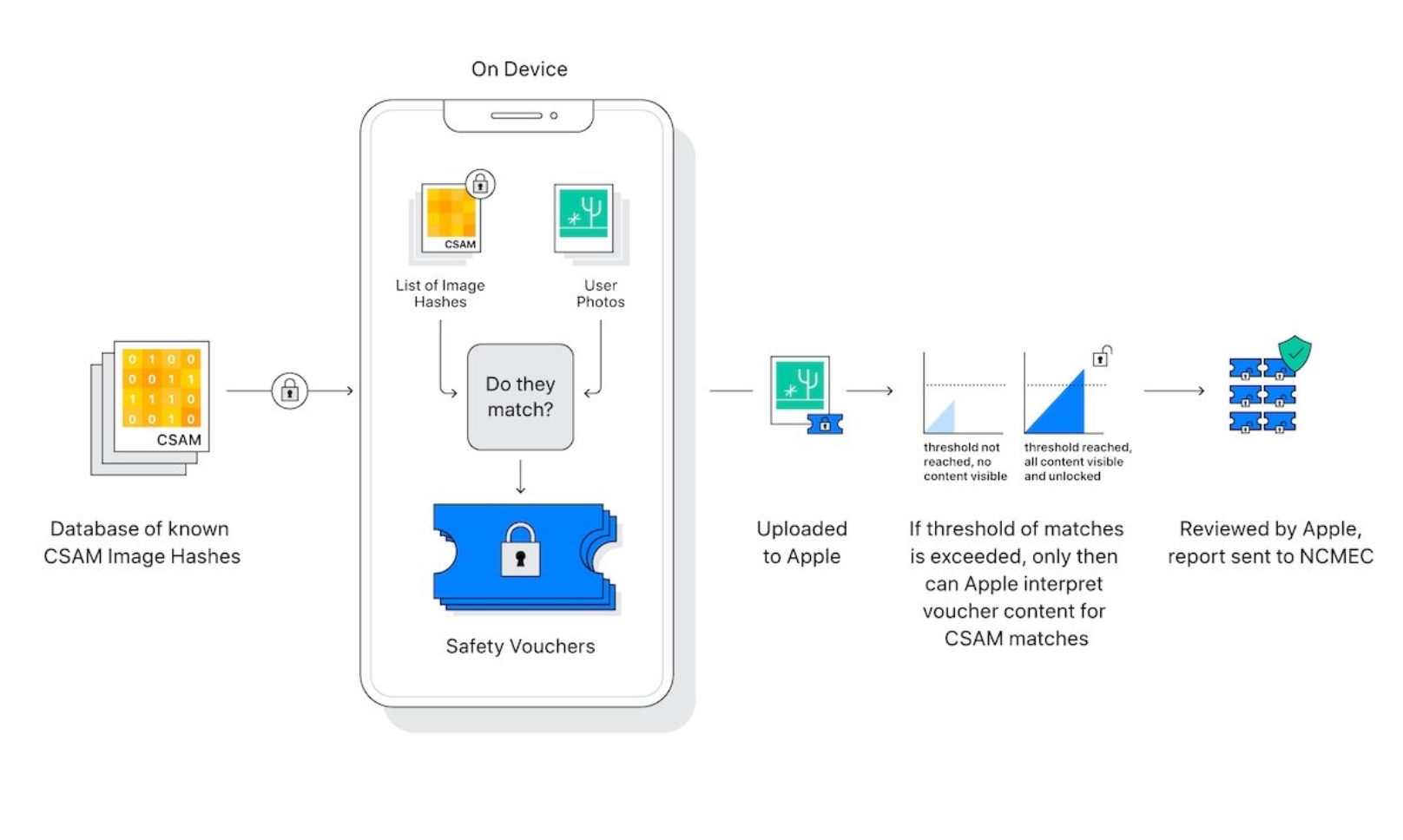

ก็ต้องบอกเลยว่า Apple เคลมว่าเทคโนโลยีตรวจจับ CSAM มีความแม่นยำสูงมาก ความผิดพลาดในการตรวจผิดจะมีโอกาสเกิดน้อยมาก เพราะว่า ซอฟท์แวร์ทำหน้าที่แค่สแกนเบื้องต้น โดยการสแกนไฟล์ Media ที่กำลังจะอัปโหลดไปใส่iCloud เท่านั้น! ไม่ได้สแกนไฟล์ทั้งหมด และเมื่อซอฟท์แวร์ดังกล่าวสแกนเจอ ก็จะมีการแจ้งเตือนไปทาง Apple เพื่อถอดรหัสไฟล์ไปให้พนักงานที่เป็นมนุษย์จริง ๆ ตรวจสอบอีกรอบ หากพบว่าเข้าข่ายก็จะแจ้งเตือนไปยังทางการเพื่อเข้ามาตรวจสอบอีกที ระบบจะทำการเปรียบเทียบกับฐานข้อมูลสื่อลามกอนาจรจากศูนย์เพื่อเด็กหายและถูกฉวยผลประโยชน์แห่งชาติของสหรัฐอเมริกา (U.S. National Center for Missing and Exploited Children : NCMEC) และองค์กรคุ้มครองเด็กอื่น ๆ

นี้เป็นฟีเจอร์แค่บางส่วนเท่านั้น ใน iOS15 ที่จะมาช่วยแก้ไขปัญหาในสังคมอย่าง การล่วงละเมิดทางเพศเด็ก (Child Sexual Abuse Material : CSAM) เพื่อเป็นหูเป็นตา เพิ่มความมั่นใจ ให้ผู้ปกครอง รวมถึงติดตามลูกหลานได้ว่าข้อมูลที่ขึ้นมาหรือที่เขาพยายามเข้าถึงเหมาะสมกับเขาหรือไม่? เบื้องต้นฟีเจอร์ทั้งหมดจะสามารถใช้ได้ใน iOS 15, iPadOS 15, watchOS 8, และ macOS Monterey ที่จะเปิดตัวในช่วงปลายปีนี้ และแน่นอนว่าจะยังสามารถใช้ได้ในสหรัฐฯ เท่านั้นนะคะ