ในทุกผลิตภัณฑ์ของ Google นั้นได้ใช้ AI เข้ามาช่วยให้ผู้ใช้ค้นหาสิ่งที่ต้องการได้แม่นยำขึ้น ไม่ว่าจะเป็น Search, Translation, Google Assistant, Google Photos และอีกหลายๆบริการ

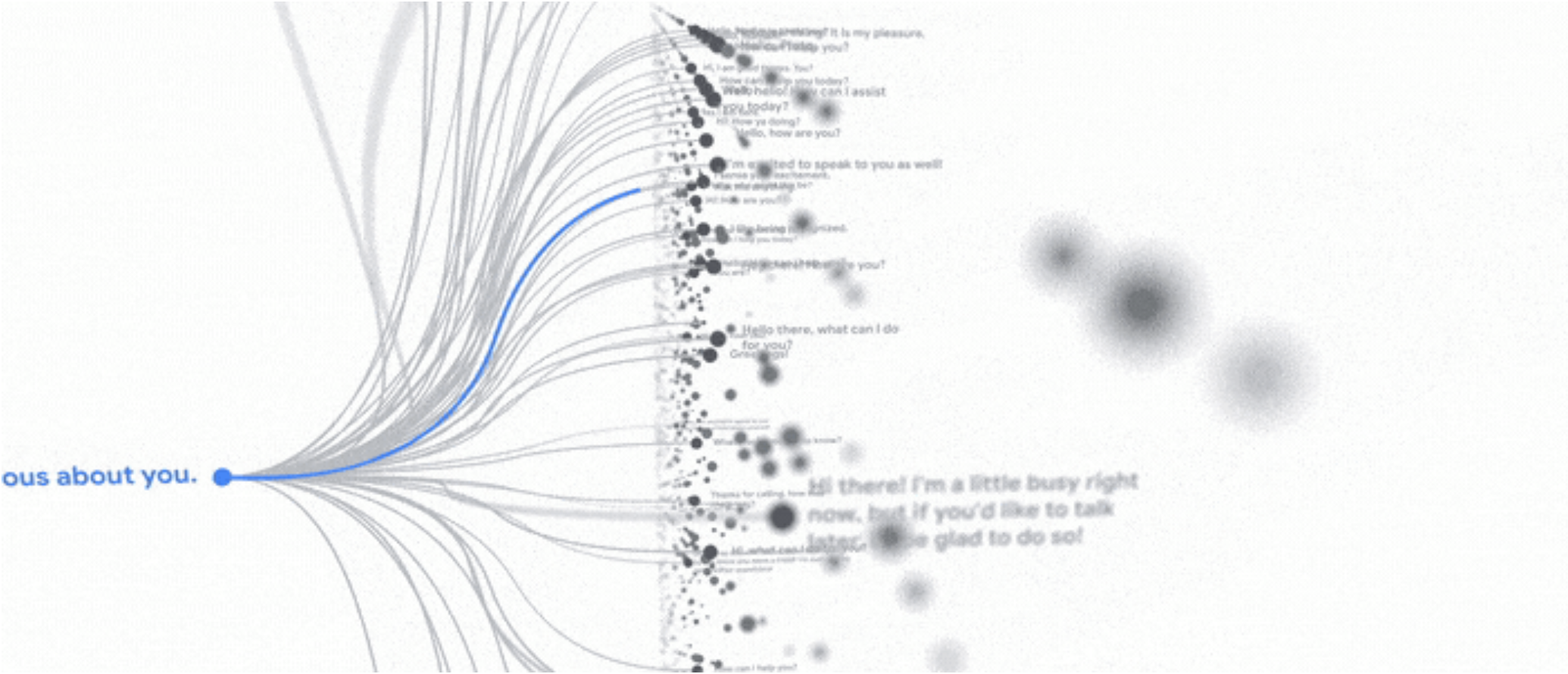

สิ่งที่ Google ให้ความสำคัญมาตลอดก็คือการพัฒนา AI ให้เข้าใจภาษาต่างๆและบริบทเพื่อให้รู้ว่าเราต้องการอะไร ซึ่งในงานปีนี้ก็มีการเปิดตัว LaMDA (Lamguage Model For Dialogue Application) ที่เข้าใจภาษาธรรมชาติได้ดียิ่งขึ้น ซึ่งตัว AI นี้เป็นแบบ open domain นั่นหมายความว่าเราสามารถคุยกับมันได้ทุกเรื่อง ในงานก็มีการสาธิตพูดคุยเกี่ยวกับดาวพลูโต ซึ่งเสียงของ AI ก็เหมือนเสียงคนจริงๆ ไม่เหมือนพูดกับหุ่นยนต์ แถมการถามตอบก็ทำได้ดีและลื่นไหลทีเดียว

ทั้งหมดนี้ยังอยู่ในช่วงเริ่มต้น ตัว LaMDA เองก็ยังมีการตอบคำถามในบางเรื่องแบบไม่สมเหตุสมผลอยู่ ดังนั้นจึงต้องมีการพัฒนาต่อเพื่อให้ตอบคำถามได้อย่างถูกต้อง แม่นยำตามมาตรฐานของ Google รวมถึงพยายามนำไปผนวกกับบริการอื่นๆ เช่น Google Assistant, Search และ Workspace นอกจากนั้นอาจจะเปิดให้นักพัฒนาและลูกค้าองค์กรสามารถนำไปใช้งานได้ด้วย

ส่วนการฝึกสอนตอนนี้จะเน้นเรื่องของข้อความเป็นหลัก ในอนาคตเขาวางแผนที่จะสร้าง multimodal models (MUM) เพื่อให้สอบถามข้อมูลด้วยวิธีอื่นๆได้ เช่น ใช้รูปภาพ/วิดีโอ เป็นต้น